Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

Tags

- neural networks #linear #nonlinear #perceptrons

- FPS

- flops

- IOU

- generalization #overfitting # bootstrapping #bagging #boosting #stochastic gradient desent #mini-batch gradient descent #batch gradient descent

- momentum #adagrad #adam #early stopping #data augmentation #dropout #label smoothing #batch normalization

- AI tech

- confusion matrix

- recall

- objectdetection

- Optimization

- 일상

- 네이버

- deep learning #machine learning #history

- CNN #padding #stride #parameters

- 1x1 convolution

- precision

- 부트캠프

- map

- 대학원생

- evaluation

Archives

- Today

- Total

목록momentum #adagrad #adam #early stopping #data augmentation #dropout #label smoothing #batch normalization (1)

공부 일기장

Optimization

Optimization

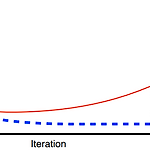

용어들에 대해서 확실하게 알고 넘어가보자 [관련 용어] Generalization 일반화 성능? - generalization gap이 작다 Under-fitting vs Over-fitting Cross-validation Bias-variance trade-off variance : 비슷한 입력들을 넣었을 때 출력 또한 일관적인지 bias : 입력들이 true target의 근처에 모여있는지 cost = bias + variance + noise trade-off 관계 Bootstrapping 여러 sampling data를 통해 여러 모델을 만드는 것 Bagging and boosting Bagging 학습데이터를 여러개를 만들어서(bootstrapping) 여러모델을 학습시키고 결과값을 평균 N개..